Integrita zpráv v éře AI: Proč AI asistenti podle rozsáhlého výzkumu stále selhávají?

Na Citace.com a našem blogu se věnujeme citování a práci se zdroji, a to i dnes, kdy při vyhledávání začínáme více využívat vyhledávání s asistencí AI než běžné vyhledávací roboty (Google, Bing a jiné) [1]. Právě proto mě zaujala zpráva o integritě a důvěryhodnosti zpráv, kterou 16. října 2025 publikovala stránka „The European Broadcasting Union“ [2].

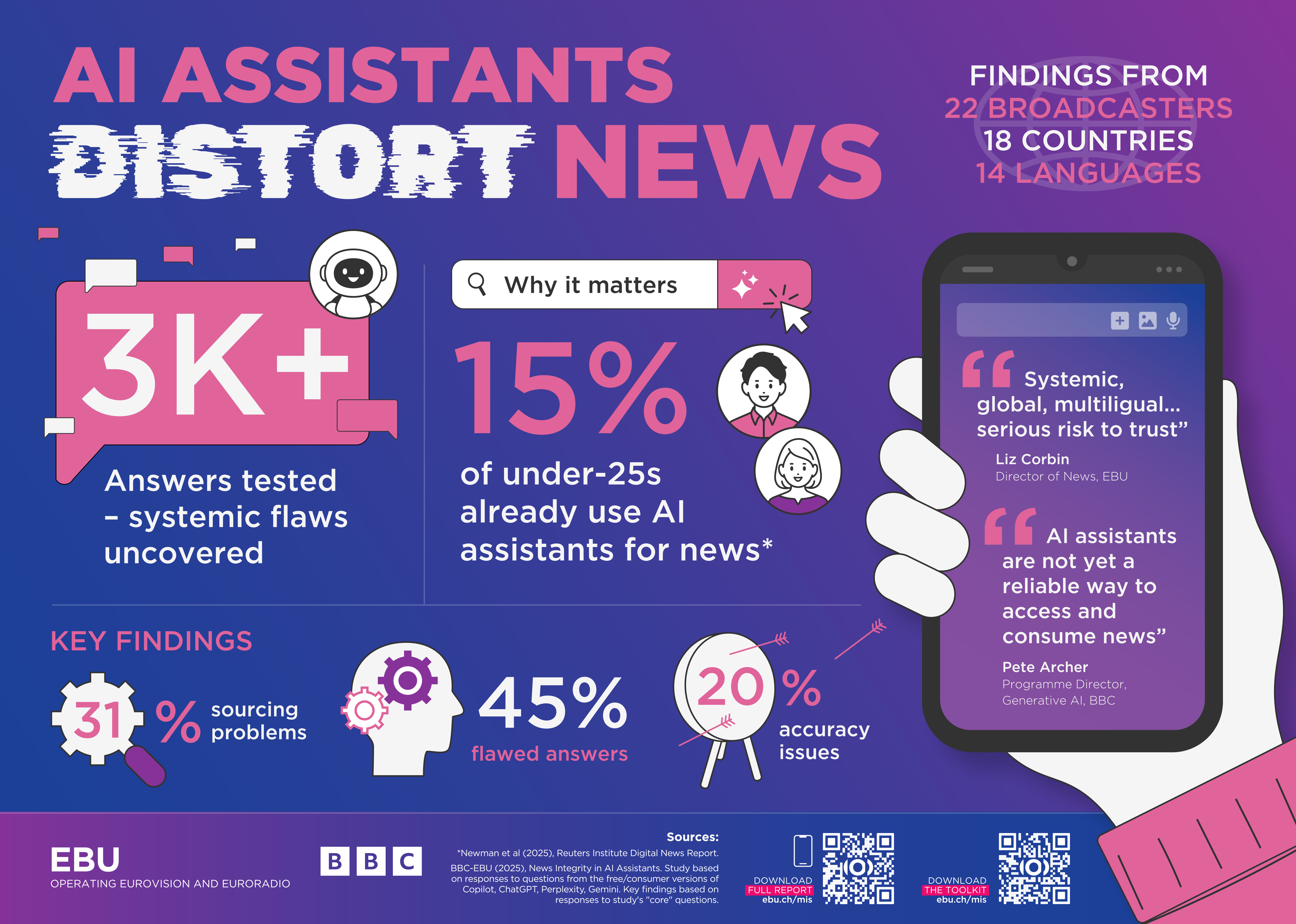

Zpráva představuje jednu z největších mezinárodních evaluací svého druhu. Testování a vyhodnocování se zúčastnilo 22 veřejnoprávních mediálních organizací (PSM) z 18 zemí, které společně testovaly, jak nejvíce využívaní AI „asistenti“ (běžně dostupné AI chatboty pro práci s textem) odpovídají na otázky týkající se zpráv a aktuálních událostí. Výzkum navázal na předchozí studii BBC, která poukázala na nepřesnosti v odpovědích AI. Cílem bylo zjistit, zda se asistenti zlepšili a zda jsou identifikované problémy systémové.

Co všechno zkoumali?

Podívali se na 4 nejpoužívanější nástroje, které jsou využívány jako AI asistenti: ChatGPT, Copilot, Perplexity a Gemini. Novináři ze zúčastněných organizací vygenerovali odpovědi na soubor 30 "základních" otázek týkajících se zpravodajství a doplnili je o volitelné "vlastní" otázky relevantní pro lokální mediální „trh“ nebo publikum dané země. Mezi participující organizace patřil například i Český rozhlas. Při zadávání promptu následně novináři kromě požadovaného dohodnutého společného zadání vložili i požadavek, aby asistent "pokud je to možné", použil zdroje dané mediální organizace (např. BBC nebo zmíněného ČRo a jiných). Zadali téměř 3000 otázek a podařilo se jim vyhodnotit 2709 odpovědí, které vyhodnocovali podle pěti klíčových kritérií:

Přesnost (Accuracy)

Uvádění zdrojů (Sourcing)

Rozlišování názoru a faktu (Opinion vs fact)

Úprava (Editorialization – přidávání hodnotícího úsudku, který nebyl ve zdroji)

Kontext (Poskytnutí dostatečného kontextu pro pochopení odpovědi).

Výsledky zprávy opravdu stojí za nahlédnutí. Doporučuji ji všem, kteří využívají nebo chtějí využívat AI asistenty pro práci se zdroji, zejména v akademické sféře. Vlastně si myslím, že by se o takových zjištěních mělo dnes debatovat šířeji a nahlas i mimo akademickou sféru. AI asistenti se dnes používají už i na středních a základních školách a využívají je jak pedagogové, tak i žáci. Co nám tedy zpráva chce říct?

Potvrdila se vysoká chybovost: Celkově 45 % všech odpovědí AI obsahovalo alespoň jeden „závažný“ problém různého typu. Pokud se započítají i "mírné" problémy, nějaký druh chyby mělo až 81 % odpovědí. To je opravdu hodně.

Uvádění zdrojů (Sourcing): Byl to největší problém ze všech. Až 31 % všech odpovědí mělo závažný problém se zdrojováním. To zahrnovalo případy, kdy informace v odpovědi nebyla podpořena citovaným zdrojem, zdroje chyběly úplně nebo došlo k nesprávné či neověřitelné atribuci zdroje. Asistent Gemini od Google zaznamenal nejvyšší míru chybovosti. Až 76 % odpovědí od Gemini mělo závažný problém. Extrémně selhal zejména ve zdrojování, kde mělo 72 % jeho odpovědí závažný problém se zdrojem. Ostatní asistenti (Copilot, ChatGPT, Perplexity) měli celkovou míru závažných problémů mezi 30 % a 37 %.

Přesnost (Accuracy): 20 % všech odpovědí mělo závažné problémy s faktickou přesností. Asistenti často poskytovali zastaralé informace, faktické chyby nebo nesprávně interpretovali údaje ze zdrojů.

Přesnost přímých citací: Z odpovědí, které obsahovaly přímou citaci, mělo 12 % závažné chyby v přesnosti této citace. Asistenti si citáty buď úplně vymýšleli (fabulovali nebo halucinovali), měnili jejich znění nebo je připisovali nesprávné osobě.

Problém "přehnané sebedůvěry" (Over-confidence): Problémy jsou často znásobeny tím, že AI asistenti poskytují nesprávné informace s vysokou mírou sebedůvěry a autoritativním tónem. Míra odmítnutí odpovědi na otázku klesla (ze 3 % v předešlém výzkumu na 0,5 %), což naznačuje, že asistenti se snaží odpovědět za každou cenu, i když nemají správné informace. Například AI asistent vám odpověď vytvoří a přisoudí ji danému médiu, i když to není pravda, nebo je to jen částečná pravda, nebo odpověď vytvoří z různých jiných zdrojů a přisoudí ji médiu, kterému tato zpráva nepatří… Scénářů je velmi mnoho. Co to může pro média znamenat? Může to ohrozit reputaci médií. Je to riziko, které podstupujeme dobrovolně každodenním používáním AI asistentů. Neuvědomujeme si, že kromě svých pozitivních stránek mají i tuto druhou stránku, o které zatím víme málo. Tím, že nesprávně zacházejí s obsahem důvěryhodných veřejnoprávních médií, podkopávají jejich neutralitu a nezaujatost. Falešně připisují výroky mediálním domům, které je neprodukovaly.

Teď, když čtu výsledky tohoto výzkumu, lépe chápu slova profesorky Márie Bielikové, a to že námi vlastně tito asistenti svým způsobem manipulují [3]. Zní to možná děsivě, ale je dobré o tom vědět. A navíc - pokud chtějí být důvěryhodná média (alespoň ta veřejnoprávní působící v demokratických režimech), je důležité, aby se o to snažily i knihovny a knihovníci.

Proto: myslete na to, citujte a ověřujte si zdroje (zejména ty, které vám poskytne AI asistent).

Ve finále by se to možná dalo shrnout jednou větou: „Tak tohle je naprd.“ [4]. Dokud však máme a chráníme si důvěryhodná média a instituce, stále se máme o co opřít. Nebo ne?

Seznam použitých zdrojů:

[1] CRANDELL, Kayleigh. The Invisible Revolution:: How AI Overviews Are Quietly Reshaping Consumer Trust and Search Behavior. Online. In: Xponent21. 2025. Dostupné z: https://xponent21.com/insights/ai-overviews-pew-research/ [cit. 2025-10-26].

[2] News Integrity in AI Assistants: An international PSM study. Online. In: The European Broadcasting Union website. Geneva: The European Broadcasting Union, 2025, s. 1-69. Dostupné z: https://www.ebu.ch/files/live/sites/ebu/files/Publications/MIS/open/EBU-MIS-BBC_News_Integrity_in_AI_Assistants_Report_2025.pdf

[cit. 2025-10-26].

[3] BIELIKOVÁ, Mária. Ako rozpoznať umelú inteligenciu, ktorá nás (z)mení. Online. Denník N. 14. 10. 2025. ISSN 1339-844X. Dostupné z: https://dennikn.sk/4899858/ako-rozpoznat-umelu-inteligenciu-ktora-nas-zmeni/

[cit. 2025-10-26].

[4] Tučňáci z Madagaskaru. Film. Český dabing. CinemArt, USA, 2014.

Henrieta Gábrišová, 2025-10-26